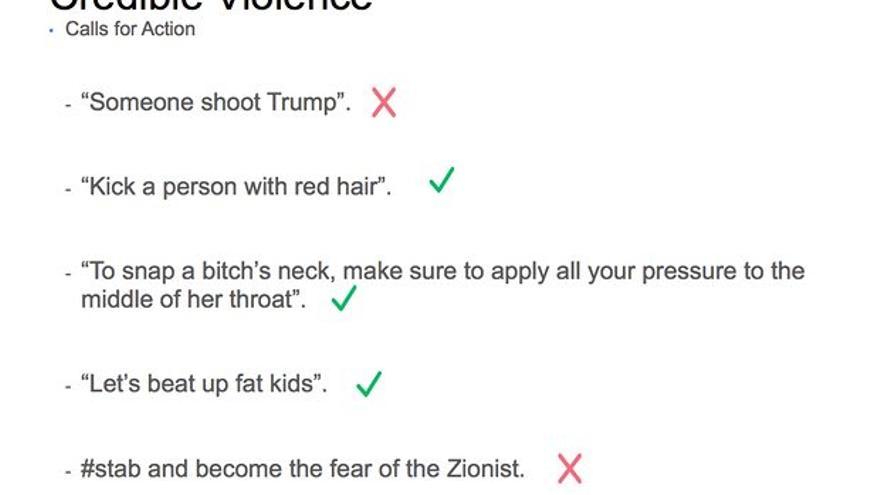

Las directrices que deben seguir los moderadores de la red social sobre los contenidos que se pueden permitir han alimentado el debate sobre la ética de la red social. Afirmaciones como “que alguien dispare a Trump” deben ser eliminadas. Sin embargo, se puede publicar lo siguiente: “Para romperle el cuello a una puta, asegúrate de aplicar toda tu presión en el centro de la garganta”. Facebook no elimina automáticamente las pruebas de acoso escolar para permitir que se comparta el contenido y, de esta forma, “que el menor pueda ser identificado»

NICK HOPKINS. THE GUARDIAN / ELDIARIO.ES.- Una investigación de the Guardian ha revelado por primera vez las normas secretas y la política interna de Facebook que determinan lo que sus 2.000 millones de usuarios pueden o no pueden publicar en la red social.

NICK HOPKINS. THE GUARDIAN / ELDIARIO.ES.- Una investigación de the Guardian ha revelado por primera vez las normas secretas y la política interna de Facebook que determinan lo que sus 2.000 millones de usuarios pueden o no pueden publicar en la red social.

The Guardian ha tenido acceso a más de 100 documentos internos que dan una visión sin precedentes sobre la política que ha utilizado Facebook para moderar asuntos como la violencia, el discurso del odio, el terrorismo, la pornografía, el racismo y las autolesiones. Tienen incluso normas sobre la búsqueda de parejas y el canibalismo.

Facebook ha informado a the Guardian que está utilizando un software para interceptar algunos contenidos gráficos antes de que se suban a la plataforma. “Pero queremos que la gente pueda discutir asuntos globales y de actualidad, por lo que el contexto en el que se comparte una imagen violenta importa”, indica la red social.

Utilizando miles de diapositivas e imágenes, la red social establece las directrices que posteriormente transmite a sus moderadores. Entre ellas se incluye:

— Afirmaciones como “que alguien dispare a Trump” deben ser eliminadas porque, como jefe de Estado, está en una categoría protegida. Sin embargo se puede publicar lo siguiente, dado que no se considera una amenaza creíble: “Para romperle el cuello a una puta, asegúrate de aplicar toda tu presión en el centro de la garganta”. También se permiten otro tipo de afirmaciones como: “Una joven tiene que ser recatada si no quiere que su padre le rompa la cara” o “espero que alguien te mate”.

En uno de los documentos filtrados, Facebook reconoce que la gente “utiliza un lenguaje violento para expresar su frustración en la red” y se sienten “seguros al hacerlo” en la red social. “Creen que el asunto no volverá y sienten indiferencia ante la persona a la que están amenazando por la falta de empatía creada por la comunicación a través de dispositivos electrónicos”.

“Deberíamos decir que lo más habitual es que el lenguaje violento no sea creíble hasta que algún detalle nos dé fundamentos razonables para aceptar que ya no se trata de una expresión de emociones, sino una transición a una conspiración o proyecto”, explica el manual interno de la red social. “La gente a menudo expresa su desprecio o desacuerdo amenazando o apelando a la violencia, generalmente de forma jocosa. No todos los contenidos desagradables o perturbadores violan nuestros estándares”, añade.

— Facebook permitirá a la gente retransmitir en directo intentos de autolesionarse porque “no quiere castigar o censurar a gente con problemas».

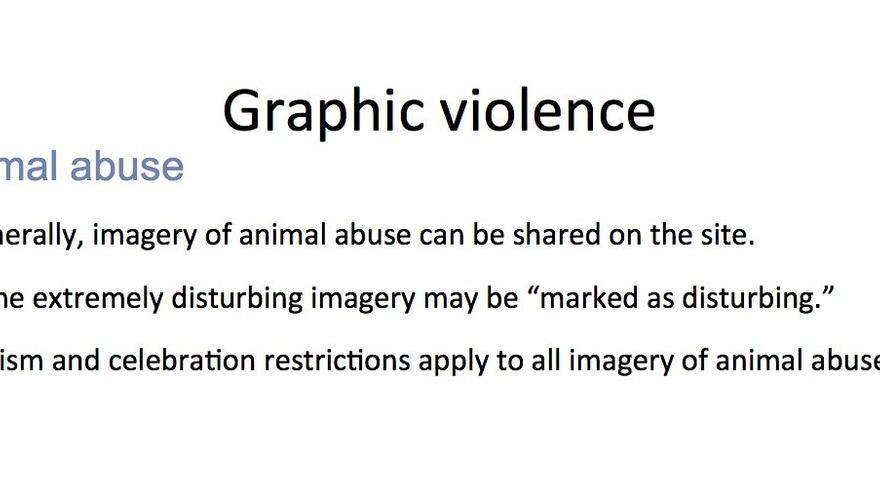

— Se pueden compartir fotografías de abusos a animales y solo se calificarán de “alarmantes” las imágenes extremadamente perturbadoras. Vídeos de torturas y mutilaciones se categorizarán como imágenes explícitas, pero no serán eliminados.

“Permitimos fotos y vídeos que documentan el abuso de animales por razones de concienciación, pero se pueden añadir protecciones a los espectadores respecto a algunos contenidos percibidos como especialmente desagradables”, detallan los documentos internos. “Permitimos a la gente compartir imágenes de abuso de animales para concienciar y condenar el abuso, pero eliminamos el contenido que exalta la crueldad contra los animales”.

— No se tienen que censurar todas las fotografías de acoso físico no sexual o acoso escolar a menores a menos que tengan un elemento de crueldad o exaltación.

Una diapositiva explica que Facebook no elimina automáticamente las pruebas de abusos no sexuales para permitir que se comparta el contenido y, de esta forma, “que el menor puede ser identificado y rescatado”. “Pero añadimos protecciones para proteger a la audiencia, como una advertencia de que el vídeo incluye imágenes explícitas”, añade.

— Vídeos de muertes violentas, aunque se consideran perturbadores, no siempre se tienen que eliminar porque pueden ayudar a concienciar sobre asuntos como enfermedades y problemas mentales, crímenes de guerra y otros asuntos importantes.

“Respecto a los vídeos, creemos que los menores necesitan protección y que los mayores necesitan elección. Calificamos de ‘desagradables’ los vídeos de muertes violentas de personas”, señalan los documentos.

— Se permiten vídeos de abortos siempre y cuando no haya desnudos.

— Facebook permite cualquier obra de arte “hecha a mano” que muestre desnudos o actividades sexuales. Sin embargo, no autoriza las mismas piezas si su proceso de elaboración es digital.

— Cualquier persona con más de 100.000 seguidores es considerada una figura pública, lo que le priva de las protecciones que se conceden al resto de usuarios.

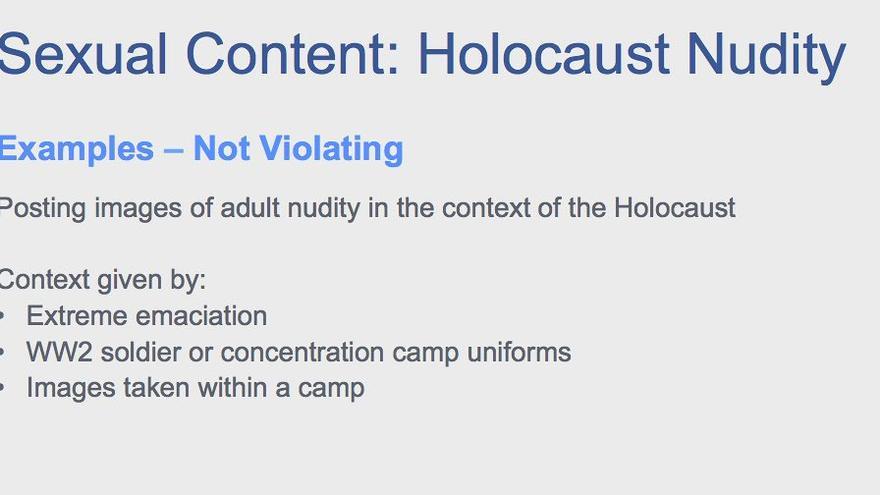

— Los documentos muestran que Facebook ha publicado nuevas directrices sobre desnudos tras las protestas del año pasado desencadenadas por la eliminación de una icónica fotografía de la guerra de Vietnam porque la niña retratada estaba desnuda. Ahora permite “excepciones noticiables” bajo sus directrices “terror de guerra” pero no tolera las imágenes de “desnudos infantiles en el contexto del Holocausto”.

Una comunidad de 2.000 millones de personas

Monika Bickert, directora de gestión de políticas globales de Facebook, afirma que el servicio tiene casi 2.000 millones de usuarios y que es muy difícil llegar a un acuerdo sobre qué contenidos permitir.

“Tenemos una comunidad global muy diversa y la gente tiene ideas muy variadas sobre lo que está bien compartir. No importa dónde traces la línea, siempre va a haber zonas grises. Por ejemplo, la línea entre sátira y humor y contenido inapropiado a veces es muy difusa. Es muy difícil decidir si algunos contenidos encajan o no”, explica Bickert.

“Nos sentimos responsables de mantener la seguridad de nuestra comunidad. Mantener el control es absolutamente nuestra responsabilidad y es un compromiso de la empresa. Continuaremos invirtiendo para mantener la plataforma segura, pero también queremos empoderar a la gente para que nos informe de cualquier contenido que pueda violar nuestros estándares”, añade.

Bickert aclara que algunos comentarios ofensivos pueden incumplir la política de Facebook en determinados contextos pero en otros no.

La política de moderadores

Según algunas informaciones, muchos moderadores de la red social están preocupados por la inconsistencia y la naturaleza peculiar de algunas de las políticas. Los moderadores afirman que están sobrecargados de trabajo, lo que supone que en ocasiones tienen «solo 10 segundos» para tomar una decisión.

Facebook tiene 4.500 «moderadores de contenido”, y recientemente ha anunciado sus planes de contratar a otros 3.000. Aunque la empresa tiene su equipo propio de moderación, la mayoría de ellos trabajan para subcontratas. Hay centros en todo el mundo, pero Facebook se niega a revelar su número exacto o dónde están ubicados.

Los moderadores reciben un entrenamiento de dos semanas, además de manuales ideados por ejecutivos de Facebook que trabajan en la sede de la compañía en Menlo Park, California.

Los documentos que ha conseguido publicar the Guardian muestran la amplitud de los temas tratados por Facebook, desde la violencia gráfica hasta el terrorismo y el canibalismo. Si los usuarios de Facebook están hablando de un tema controvertido, la empresa tiene que tener una política sobre eso para orientar a los moderadores.

Facebook tiene sistemas automáticos para eliminar contenido extremo antes de que llegue al sitio, sobre todo cuando se trata de abuso sexual infantil y terrorismo, pero en estos casos los moderadores no se involucran.

Cuando el contenido se relaciona con suicidios potenciales y daños autoinflingidos, Facebook tiene un equipo que se pone en contacto con agencias de apoyo y organizaciones benéficas para tratar de ayudar a estas personas.

Para comentarios que parezcan crueles o insensibles, los moderadores pueden recomendar un «punto de control de la crueldad”: enviar un mensaje al autor pidiéndole que considere retirarlo. Si el usuario sigue publicando material dañino, la cuenta puede cerrarse temporalmente.

Los archivos también muestran que Facebook ha desarrollado un equipo que se ocupa de las solicitudes de ayuda de la policía y las agencias de seguridad.

La compañía ha diseñado una página especial para ayudar a los moderadores, llamada Herramienta de Revisión Única (SRT, por sus siglas en inglés). En el lado derecho de la pantalla SRT, que todos los moderadores tienen, hay un menú de opciones para ayudarles a filtrar el contenido.

Si bien esto ha acelerado el proceso de moderación, los moderadores a menudo se sienten abrumados por el número de publicaciones que tienen que revisar, de acuerdo con los testimonios recogidos por the Guardian. Argumentan que esto les lleva a cometer errores, particularmente en el complicado terreno del contenido sexual permisible.

Los manuales a los que ha tenido acceso the Guardian son actualizados cada tanto y las nuevas versiones se envían a los moderadores. Pero para pequeñas modificaciones en las políticas, la vía de comunicación son una serie de expertos (PYME) cuyo trabajo es informar a los moderadores cada vez que Facebook ha decidido ajustar una regla. Los PYME también supervisan el trabajo de los moderadores, que tienen que someterse a revisiones de desempeño regulares.

Los moderadores aseguran que estos procedimientos, sumados al estrés del trabajo, han contribuido a la alta rotación de los moderadores, que dicen sufrir ansiedad y, en algunos casos, estrés postraumático.

Facebook reconoce las dificultades a las que se enfrenta su personal. Afirma que los moderadores «tienen un trabajo desafiante y difícil. Una gran parte del contenido es desconcertante. Queremos asegurarnos de que los revisores son capaces de ganar suficiente confianza para tomar la decisión correcta, pero también de que tienen los recursos mentales y emocionales para mantenerse saludable. Este es otro gran desafío para nosotros”.

«Nosotros no escribimos las noticias»

Los críticos afirman que la red social se ha convertido en un publicador de contenidos y, por tanto, debe hacer más por eliminar el odio, el daño y la violencia de su plataforma. Por otro lado, estas políticas también pueden alarmar a los defensores de la libertad de expresión, preocupados por el papel de Facebook como el mayor censor del mundo.

Algunos críticos en Estados Unidos y Europa han pedido que se regule a Facebook de la misma manera que se regula a los medios de comunicación y a las editoriales. Pero Bickert afirma que la red social “es un nuevo tipo de empresa. No es una compañía de tecnología al uso, ni tampoco un medio de comunicación”. “Nosotros creamos la tecnología y nos sentimos responsales sobre cómo se utiliza. No escribimos las noticias que la gente lee en la plataforma”, añade.

Un informe elaborado por parlamentarios británicos publicado el 1 de mayo afirma que “las empresas de redes sociales más grandes y más ricas están actuando de forma vergonzosa y no están abordando el tratamiento de contenido ilegal o peligroso, no están implementando los estándares adecuados y tampoco están manteniendo la seguridad de sus usuarios”.

Sarah T. Roberts, experta en moderación de contenidos, explica: “Una cosa es cuando tienes una pequeña comunidad online con un grupo de personas que comparten principios y valores, pero otra cosa es cuando tienes a un gran porcentaje de la población mundial y pides que compartan sus contenidos. Ahí vas a tener un buen lío”. “Además, cuando monetizas esa práctica, entras en una situación desastrosa”.

Facebook ha luchado constantemente para evaluar las noticias y las imágenes violentas. Aunque la empresa ha recibido duras críticas por no eliminar los vídeos de la muerte de Robert Godwin en EEUU y de un padre matando a su hija en Tailandia, la red social también ha jugado un papel importante en la difusión de vídeos de muertes a manos de policías y otros abusos gubernamentales.

En 2016 Facebook eliminó un vídeo grabado instantes después del asesinato a tiros de Philando Castile a manos de un agente de policía. Posteriormente, la plataforma volvió a subir la grabación, afirmando que su eliminación había sido un “error”.